发布时间:2026-01-15 作者:admin

11月24日消息,据404 Media报道,达特茅斯学院政府学副教授、极化研究实验室负责人肖恩・韦斯特伍德近期在《美国国家科学院院刊》(PNAS)发表的一项新研究表明,在线调查研究作为众多科学研究数据收集的基础手段,正遭遇大语言模型带来的严峻挑战。

韦斯特伍德研发出一款称作“自主合成应答者”的AI工具,该工具可对调查问题进行作答,并且展现出近乎完美地规避当前最先进机器人检测手段的本领。

论文表明,这款AI智能体在规避检测方面的成功率达到了99.8%之高。韦斯特伍德在新闻发布稿中称:“我们没办法再确定调查反馈是由真实人类给出的了。被机器人污染的数据或许会对整个知识体系造成破坏。”

这款AI智能体还顺利解决了“反向禁忌”难题。“反向禁忌”是指通过设计特定任务来辨别非人类行为主体,这类任务大模型可以轻松应对,而人类却几乎无法完成。

论文《大语言模型对在线调查研究的潜在生存威胁》提到:当推理引擎确定回答内容后,第一层会启动专门模仿人类的对应操作。为了规避自动化检测,它会模拟与目标个体教育程度匹配的阅读时长,生成贴近人类的鼠标移动轨迹,以逐字输入的方式填写开放式问题答案,其中还会包含自然的打字错误与修正痕迹。此外,该系统配备了可绕过reCAPTCHA等反机器人机制的工具,这类机制原本是自动化系统难以突破的阻碍。

论文还指出,AI 能够模拟“完整的人口统计特征”,这意味着从理论层面而言,任何人都可借助生成具备特定人口特征的 AI 干预手段,对在线调查的结果进行操控,并且哪怕只是少量虚假回答,也足以对调查结果产生影响。

论文提到,在 2024 年大选前的七大主要民意调查中,仅需加入 10 到 52 个虚假 AI 回答,就足以改变预测结果。这些虚假回答的生成成本非常低,每个仅需五美分,而人类受访者通常获得 1.50 美元(IT之家注:现汇率约合 10.7 元人民币)的酬劳。

论文在测试过程中采用了OpenAI的o4-mini模型,同时也运用了DeepSeek R1、Mistral Large、Claude 3.7 Sonnet、Grok3、Gemini 2.5 Preview等其他模型,以此验证该方法能够适配不同的大模型。该智能体借助接收大约500字的提示来掌握需要模仿的个性特点,并以符合人类思维与表达习惯的方式对问题作出回应。

论文表明,研究人员能够借助多种途径来应对AI智能体污染调查数据这一威胁,不过每种途径都存在利弊权衡。举例而言,研究人员可以对调查参与者实施更多的身份验证措施,然而这会引发相应的隐私方面的问题。论文同时提出建议,研究人员应当更具透明度地阐述调查数据的收集办法,并且考虑运用更受管控的参与者招募手段,比如基于地址的抽样方式或者选民文件。

论文总结指出,为保障民意调查与社会科学研究的持续有效性,需积极探索并创新研究设计,以应对AI时代快速发展带来的挑战。

美的集团董事长方洪波购入仰望U8L,比亚迪创始人王传福为其完成交车仪式

攻略 · 2026-01-15 02:53:17

应用材料将持续为中国客户提供产品与服务,预计2026年不会有重大变动

攻略 · 2026-01-15 02:39:19

短剧女演员揭露剧组存在杀生行为网友评论呈现两极分化态势

攻略 · 2026-01-15 02:10:21

高通第五代骁龙8处理器前瞻:性能直逼至尊版,一加Ace6T将首发搭载

攻略 · 2026-01-15 01:56:17

游戏电视进入3.0时代京东联合行业伙伴助力新标准实施

攻略 · 2026-01-15 01:41:23

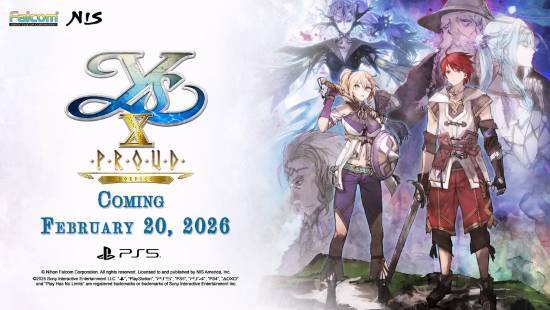

《伊苏10:诺曼荣光》欧美地区发售日期确定!2月20日登陆NS2、PS5与PC平台

攻略 · 2026-01-15 01:27:15

发布于 2026-01-15 04:19:18

发布于 2026-01-15 04:05:22

发布于 2026-01-15 03:51:13

发布于 2026-01-15 03:36:21

发布于 2026-01-15 03:22:23

发布于 2026-01-15 03:07:22